Data Pipeline Là Gì? Tầm Quan Trọng Của Data Pipeline Trong Xử Lý Dữ Liệu

Dữ liệu là “chìa khóa vàng” giúp doanh nghiệp mở rộng kế hoạch kinh doanh và đánh giá kết quả hoạt động dựa trên các chiến dịch đã thực hiện. Chiến dịch càng lớn, càng phức tạp thì nguồn data thu về sẽ rải rác trên nhiều nền tảng, đòi hỏi phải có giải pháp tổng hợp và xử lý dữ liệu để chuyển đổi chúng thành thông tin giá trị. Và Data Pipeline chính là nền tảng đóng vai trò trung gian quan trọng trong quy trình này. Để hiểu rõ hơn về khái niệm Data Pipeline là gì cũng như những lợi ích và ứng dụng tuyệt vời của nó, mời bạn theo dõi nội dung bài viết dưới đây của Học Viện Công Nghệ Thông Tin – Hướng Nghiệp Á Âu nhé!

Data Pipeline là cầu nối chuyển đổi dữ liệu thô thành những dạng thông tin hữu ích

(Ảnh: Internet)

Data Pipeline Là Gì?

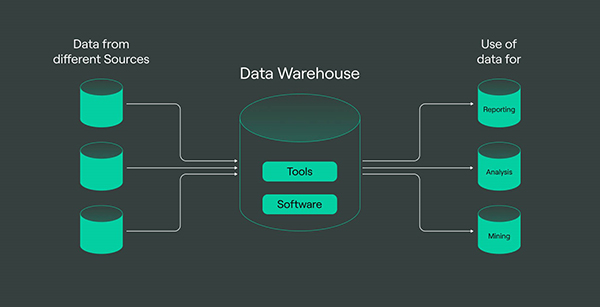

Data Pipeline, hay còn được gọi là đường ống dữ liệu, là phương pháp thu thập dữ liệu thô từ nhiều nguồn khác nhau, sau đó được chuyển đến kho dữ liệu để phục vụ quá trình phân tích. Quy trình truyền dẫn này bao gồm các bước như thu thập, lọc dữ liệu, định dạng dữ liệu, chuẩn hóa dữ liệu, tổng hợp dữ liệu…

Data Pipeline là một hệ thống quản lý luồng dữ liệu tối ưu, giúp doanh nghiệp dễ dàng đồng nhất số liệu và phân tích thông tin hiệu quả trong môi trường có số lượng data đến từ nhiều nguồn khác nhau như SQL, MySQL, API, tệp tin…

Với nhu cầu xử lý dữ liệu ngày càng lớn và phức tạp, Data Pipeline đã trở thành một hệ thống phổ biến trong các lĩnh vực như tài chính, kinh doanh, thương mại điện tử, truyền thông – marketing…

Data Pipeline đóng vai trò quan trọng trong lĩnh vực xử lý số liệu (Ảnh: Internet)

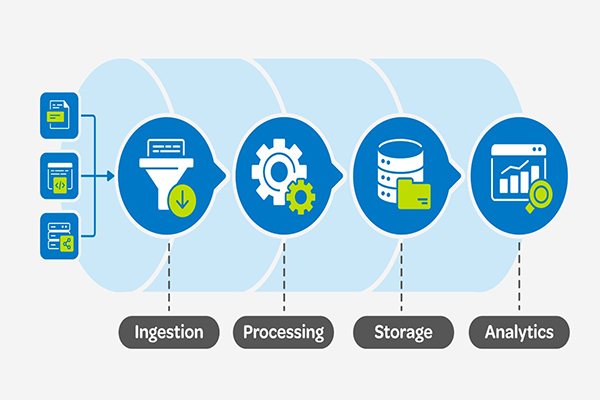

3 Bước Tạo Nên Kiến Trúc Của Data Pipeline

Bước 1: Nhập Dữ Liệu (Data Ingestion)

Đầu tiên, dữ liệu sẽ được thu thập từ nhiều nguồn như nhà sản xuất, khách hàng, ứng dụng trực tuyến… Sau khi tổng hợp đầy đủ, dữ liệu sẽ được chuyển vào hệ thống Data Pipeline để tiếp tục xử lý.

Bước 2: Chuyển Đổi Dữ Liệu (Data Transformation)

Chuyển đổi dữ liệu là quá trình biến đổi dữ liệu từ dạng thô ban đầu thành định dạng phù hợp để bắt đầu thực hiện các bước phân tích dữ liệu. Giai đoạn này thường bao gồm các bước: chọn lọc dữ liệu, đồng nhất dữ liệu, tách/ghép dữ liệu, chuyển đổi định dạng…

Bước 3: Lưu Trữ Dữ Liệu (Data Storage)

Data Storage là nơi lưu trữ kết quả của quá trình chuyển đổi dữ liệu. Tổng hợp dữ liệu sẽ được lưu trữ dưới nhiều hình thức như: Data Warehouse, Database, File Systems, Data Lake, Cloud Storage… Đây là bước tạo ra “thành phẩm” của hệ thống Data Pipeline, đồng thời cũng là quá trình tạo ra “nguyên liệu” cho các phương pháp phân tích dữ liệu tiếp theo.

Data Pipeline được xem là hệ thống chuẩn bị dữ liệu hoàn hảo cho quá trình analytics

(Ảnh: Internet)

Vai Trò Quan Trọng Của Data Pipeline Trong Xử Lý Dữ Liệu

Trước hết, Data Pipeline giúp doanh nghiệp loại bỏ những sai sót chủ quan do yếu tố con người trong quá trình nhập liệu và tổng hợp số liệu. Hơn nữa, hệ thống này đảm bảo rằng dữ liệu luôn sẵn sàng phục vụ cho mọi nhu cầu phân tích.

Đối với những doanh nghiệp lớn, dữ liệu tuyệt đối không được lưu trữ ở một hệ thống nhất định mà thường phải lưu trữ ở nhiều nơi khác nhau. Data Pipeline có khả năng hợp nhất dữ liệu từ các nguồn này thành một kho thông tin hoàn chỉnh, đồng nhất và liền mạch.

Data Pipeline giữ chức năng quan trọng trong các hệ thống hiện đại,

yêu cầu xử lý số liệu nhanh chóng và chính xác (Ảnh: Internet)

Data Pipeline giúp nâng cao hiệu suất xử lý số liệu. Bằng những phương thức di chuyển và biến đổi dữ liệu nhanh chóng, Data Pipeline có thể cập nhật kho dữ liệu ngay tức thời, điều này có ý nghĩa đặc biệt quan trọng trong hoạt động phân tích hành vi khách hàng, kiểm soát hệ thống, theo dõi giao dịch trực tuyến…

Đặc biệt, dữ liệu được xử lý qua hệ thống Data Pipeline sẽ tạo thuận lợi và tiết kiệm thời gian cho việc phân tích dữ liệu. Với sự phát triển của công nghệ, ứng dụng phần mềm hiện đại thì việc tính toán, thu thập và xử lý số liệu trở nên ngày càng phức tạp. Data Pipeline được tận dụng để khai thác dữ liệu và tăng khả năng chịu tải của hệ thống. Nhờ vào quy trình xử lý và phân tích dữ liệu nhanh chóng, doanh nghiệp có thể đưa ra những quyết định chiến lược dựa trên nguồn tổng hợp dữ liệu chính xác và kịp thời.

Các Loại Data Pipeline Phổ Biến Nhất

Dựa vào mục đích và cách thức hoạt động, Data Pipeline được chia thành một số loại phổ biến sau đây:

Batch Data Pipeline

Đây là loại đường ống dữ liệu có khả năng xử lý hàng loạt lô dữ liệu tại các thời điểm định kỳ. Batch Data Pipeline phù hợp với những doanh nghiệp không yêu cầu phân tích dữ liệu trong thời gian thực và thường được dùng với mục đích tích hợp và phân tích dữ liệu theo từng cột mốc.

Streaming Data Pipeline

Loại Data Pipeline này được sử dụng để xử lý nguồn dữ liệu liên tục và không ngừng. Đặc điểm của Streaming Data Pipeline là có tốc độ xử lý luồng dữ liệu nhanh chóng, dữ liệu sẽ được xử lý ngay sau khi được đưa vào hệ thống.

Hybrid Data Pipeline

Là sự kết hợp giữa Batch Data Pipeline và Streaming Data Pipeline để giải quyết những yêu cầu phức tạp của hệ thống hiện đại.

Cloud Data Pipeline

Là loại Data Pipeline được vận hành trên môi trường đám mây, toàn bộ tài nguyên dữ liệu sẽ được chuyển đến, xử lý và lưu trữ bằng dịch vụ đám mây.

Ứng Dụng Quan Trọng Của Data Pipeline

Data Visualization

Hệ thống Data Pipeline chính là bước gián tiếp để tạo ra Visualization từ dữ liệu. Bằng nguồn dữ liệu “sạch” sau quá trình xử lý, các nhà phân tích có thể dễ dàng tạo ra các biểu đồ, bảng vẽ, đồ thị… một cách trực quan và hấp dẫn để truyền đạt cụ thể giá trị của dữ liệu đến từ nhiều nguồn khác nhau. Tham khảo khóa học trực quan hóa dữ liệu tại Học Viện Công Nghệ Thông Tin Á Âu, học cách kể chuyện bằng dữ liệu, trình bày kết quả phân tích rõ ràng, mạch lạc và hấp dẫn.

Data Pipeline có mối quan hệ mật thiết với Data Visualization (Ảnh: Internet)

Phân Tích Dữ Liệu

Bằng các bước xử lý data như thu thập, làm sạch, định dạng và chuẩn hóa dữ liệu, Data Pipeline đảm nhận vai trò chuẩn bị dữ liệu trước khi thực hiện các bước phân tích.

Nếu trực tiếp đưa nguồn dữ liệu thô vào quá trình phân tích dữ liệu mà không trải qua các bước xử lý thì kết quả sẽ không đồng nhất và tồn tại nhiều sai sót. Vì vậy, Data Pipeline đóng vai trò như một bộ máy kiểm soát dữ liệu, đảm bảo kết quả được tạo ra một cách chính xác, toàn diện và hiệu quả.

Machine Learning

Data Pipeline được ứng dụng đa dạng trong lĩnh vực học máy như đồng bộ data, chuẩn hóa mô hình dữ liệu và đưa ra những dự án quan trọng dựa trên dữ liệu.

Data Pipeline đã và đang chứng tỏ sức ảnh hưởng to lớn trong Machine Learning

(Ảnh: Internet)

Với sự phát triển của công nghệ hiện đại và nhu cầu xử lý số liệu ngày càng tăng, Data Pipeline đang trở thành một phần không thể thiếu trong hệ thống quản lý và xử lý dữ liệu của nhiều doanh nghiệp. Hy vọng, thông qua bài viết sẽ giúp bạn hiểu rõ hơn về khái niệm Data Pipeline là gì cũng như những lợi ích tuyệt vời mà công cụ này mang lại. Cùng đón xem những bài viết tiếp theo của Học Viện Công Nghệ Thông Tin – Hướng Nghiệp Á Âu để khám phá thêm nhiều kiến thức và giải pháp công nghệ hàng đầu hiện nay.

ĐƠN VỊ TUYỂN DỤNG CHEFJOB.VN

ĐẦU BẾP - BẾP BÁNH - PHA CHẾ - PHỤC VỤ - BUỒNG PHÒNG

LỄ TÂN - QUẢN LÝ NHÀ HÀNG - KHÁCH SẠN

Hotline: 1900 2175 - Web: www.chefjob.vn

SIÊU THỊ ĐVP MARKET

Chuyên bán sỉ lẻ Nguyên liệu - Dụng cụ - Máy móc

TRÀ SỮA - CAFÉ - QUÁN ĂN - QUÁN KEM - KINH DOANH BÁNH

Hotline: 028 7300 1770 - Web: www.dvpmarket.com

Có (0) bình luận cho: Data Pipeline Là Gì? Tầm Quan Trọng Của Data Pipeline Trong Xử Lý Dữ Liệu

Chưa có đánh giá nào.